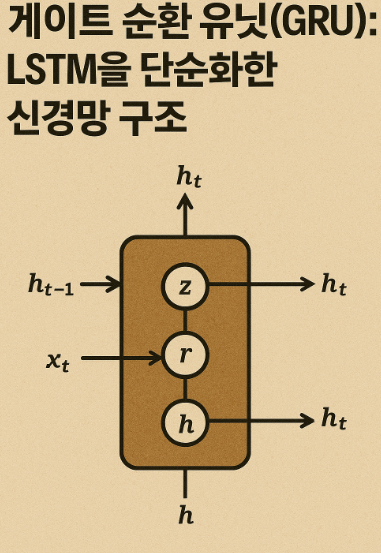

게이트 순환 유닛(GRU): LSTM을 단순화한 신경망 구조

GRU는 장단기 메모리(LSTM) 네트워크의 복잡성을 줄이면서도 유사한 성능을 제공하는 혁신적인 순환 신경망 구조입니다.

GRU란 무엇인가?

게이트 순환 유닛(Gated Recurrent Unit, GRU)은 2014년 Kyunghyun Cho 등이 제안한 순환 신경망(RNN)의 한 종류로, 장단기 메모리(LSTM) 네트워크의 단순화된 버전입니다. GRU는 LSTM과 유사한 성능을 유지하면서도 구조를 단순화하여 계산 효율성을 높였습니다.

GRU의 내부 구조를 보여주는 다이어그램

GRU의 핵심 아이디어

GRU는 '게이트' 메커니즘을 사용하여 정보의 흐름을 제어합니다. 이 게이트들은 네트워크가 장기적인 의존성을 학습할 수 있도록 도와주며, 기존 RNN의 기울기 소실 문제를 완화합니다.

GRU의 주요 구성 요소

GRU는 두 가지 주요 게이트로 구성됩니다:

- 리셋 게이트(Reset Gate): 현재 입력과 이전 상태를 얼마나 잊어야 하는지 결정

- 업데이트 게이트(Update Gate): 이전 상태의 정보를 얼마나 유지할지 결정

GRU의 리셋 게이트와 업데이트 게이트 작동 방식

GRU의 수학적 표현

GRU의 작동은 다음 수식으로 표현됩니다:

- 업데이트 게이트: z_t = σ(W_z · [h_{t-1}, x_t])

- 리셋 게이트: r_t = σ(W_r · [h_{t-1}, x_t])

- 후보 은닉 상태: ̃h_t = tanh(W · [r_t * h_{t-1}, x_t])

- 최종 은닉 상태: h_t = (1 - z_t) * h_{t-1} + z_t * ̃h_t

GRU vs LSTM: 주요 차이점

| 특징 | GRU | LSTM |

|---|---|---|

| 게이트 수 | 2개 (리셋, 업데이트) | 3개 (입력, 망각, 출력) |

| 메모리 셀 | 없음 | 있음 |

| 파라미터 수 | 적음 (단순한 구조) | 많음 (복잡한 구조) |

| 계산 효율성 | 높음 | 상대적으로 낮음 |

| 학습 속도 | 빠름 | 상대적으로 느림 |

GRU가 항상 LSTM보다 우월한 것은 아닙니다. 데이터셋과 문제의 특성에 따라 LSTM이 더 나은 성능을 보일 수 있습니다.

GRU의 장점과 응용 분야

GRU의 주요 장점

- LSTM보다 간단한 구조로 계산 효율성 향상

- 적은 수의 파라미터로 빠른 학습 가능

- 기울기 소실 문제 완화

- 장기 의존성 학습 능력 보유

GRU의 응용 분야

- 자연어 처리 (기계 번역, 텍스트 생성)

- 음성 인식

- 시계열 예측

- 비디오 분석

- 음악 생성

GRU는 특히 리소스가 제한된 환경이나 실시간 처리가 필요한 애플리케이션에서 LSTM에 비해 유리합니다.

GRU의 미래와 발전 방향

GRU는 계속해서 활발히 연구되고 있는 분야입니다. 최근 연구들은 다음과 같은 방향으로 GRU를 발전시키고 있습니다:

- Attention 메커니즘과의 결합: GRU에 attention을 도입하여 중요한 정보에 더 집중

- 양방향 GRU: 과거와 미래 정보를 모두 활용하는 양방향 아키텍처

- 계층적 GRU: 여러 층의 GRU를 쌓아 더 복잡한 패턴 학습

- 경량화 GRU: 모바일 기기에서도 실행 가능한 경량 버전 개발

GRU 기술의 미래 응용 분야 예측

반응형

'IT&과학 > 인공지능' 카테고리의 다른 글

| 변이형 자기부호화기(VAE): 생성형 AI의 핵심 기술 (0) | 2025.04.21 |

|---|---|

| 자기부호화기(Autoencoder): 데이터 압축과 복원의 신경망 마법 (0) | 2025.04.20 |

| 장단기 메모리(LSTM): RNN의 혁신적 발전과 응용 분야 (0) | 2025.04.20 |

| 순환 신경망(RNN): 순차 데이터 처리의 핵심 기술 (0) | 2025.04.19 |

| 합성곱 신경망(CNN): 이미지 인식의 혁명을 이끄는 AI 기술 (0) | 2025.04.19 |