변형형 자기부호화기(VAE)

생성형 인공지능의 혁신을 이끄는 확률적 자기부호화기 기술

VAE란 무엇인가?

변형형 자기부호화기(Variational Autoencoder, VAE)는 2013년 Kingma와 Welling이 제안한 생성 모델로, 기존의 자기부호화기(Autoencoder)에 확률적 접근을 도입한 심층 학습 모델입니다. VAE는 데이터의 잠재 표현(latent representation)을 학습하고, 이를 바탕으로 새로운 데이터를 생성할 수 있는 능력을 갖추고 있습니다.

핵심 개념

VAE는 입력 데이터를 저차원의 잠재 공간(latent space)에 매핑하고, 이 공간에서 샘플링을 통해 새로운 데이터를 생성합니다. 이 과정에서 확률적 방법론을 사용하여 데이터의 분포를 학습합니다.

VAE의 작동 원리

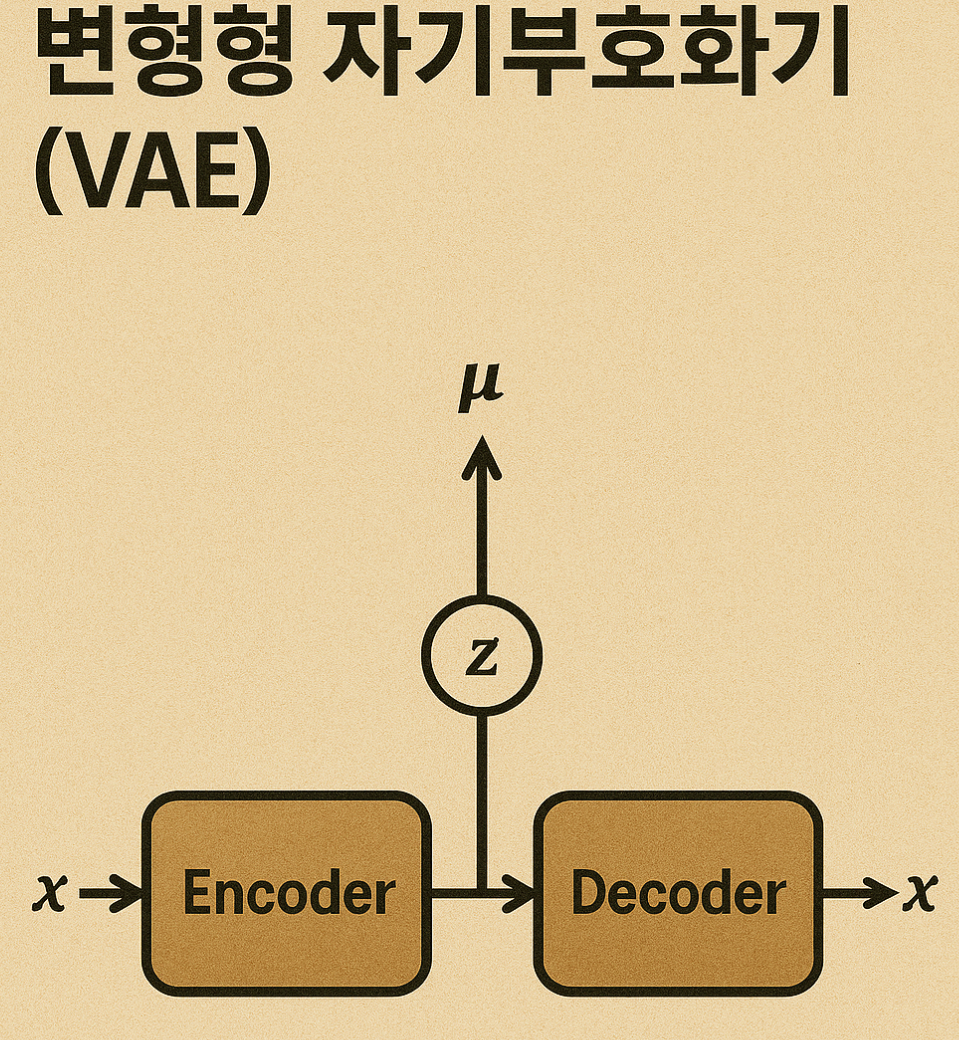

1. 인코더-디코더 구조

VAE는 기본적으로 두 개의 신경망으로 구성됩니다:

- 인코더(Encoder): 입력 데이터를 잠재 변수(latent variables)의 분포로 변환

- 디코더(Decoder): 잠재 변수에서 원본 데이터를 재구성하거나 새로운 데이터 생성

2. 확률적 접근

기존 자기부호화기와 달리 VAE는 잠재 공간에 확률 분포(보통 가우시안 분포)를 가정합니다. 인코더는 입력 데이터를 평균(μ)과 분산(σ)으로 매핑하며, 이 분포에서 샘플링을 통해 잠재 변수 z를 얻습니다.

KL 발산(Kullback-Leibler divergence): VAE는 잠재 변수의 분포가 표준 정규 분포에 가깝도록 유도하기 위해 KL 발산을 사용합니다. 이는 생성 과정의 규제 역할을 합니다.

VAE의 주요 장점

1. 생성 능력

잠재 공간에서의 샘플링을 통해 완전히 새로운 데이터를 생성할 수 있습니다. 이는 이미지, 음악, 텍스트 등 다양한 도메인에 적용 가능합니다.

2. 잠재 공간의 의미론적 특성

잠재 공간은 의미론적으로 부드럽게 변화하는 특성을 가지며, 벡터 연산을 통해 데이터 속성을 제어할 수 있습니다.

3. 데이터 압축 및 노이즈 제거

기존 자기부호화기와 마찬가지로 데이터의 효율적인 표현을 학습하므로 데이터 압축 및 노이즈 제거에 활용될 수 있습니다.

VAE vs 전통적 자기부호화기

| 특징 | 전통적 자기부호화기 | 변형형 자기부호화기(VAE) |

|---|---|---|

| 잠재 공간 표현 | 고정된 값 | 확률 분포(μ, σ) |

| 생성 능력 | 제한적 | 뛰어남 |

| 잠재 공간 특성 | 불연속적 | 연속적이고 의미론적 |

| 학습 목적 함수 | 재구성 오차 최소화 | ELBO(Evidence Lower Bound) 최대화 |

| 주요 활용 분야 | 차원 축소, 특징 추출 | 데이터 생성, 특징 추출, 이상 탐지 |

VAE의 실제 응용 분야

- 이미지 생성: 새로운 얼굴, 풍경, 예술 작품 생성

- 이상 탐지: 정상 데이터 분포 학습을 통해 이상치 탐지

- 의료 영상: MRI, CT 스캔 데이터의 효율적 표현 및 생성

- 추천 시스템: 사용자 취향의 잠재적 표현 학습

- 음성 합성: 자연스러운 음성 생성

최신 연구 동향: 최근에는 VAE를 더욱 개선한 모델들(β-VAE, VQ-VAE, NVAE 등)이 등장하며 생성 품질과 안정성을 크게 향상시키고 있습니다. 특히 확산 모델(Diffusion Models)과의 결합은 이미지 생성 분야에서 혁신적인 결과를 보여주고 있습니다.

VAE 구현의 실제 예시

간단한 VAE 모델 구조 (PyTorch 예시)

class VAE(nn.Module):

def __init__(self, input_dim, hidden_dim, latent_dim):

super(VAE, self).__init__()

# 인코더

self.encoder = nn.Sequential(

nn.Linear(input_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, latent_dim*2) # μ와 log(σ²) 출력

# 디코더

self.decoder = nn.Sequential(

nn.Linear(latent_dim, hidden_dim),

nn.ReLU(),

nn.Linear(hidden_dim, input_dim),

nn.Sigmoid())

def reparameterize(self, mu, logvar):

std = torch.exp(0.5*logvar)

eps = torch.randn_like(std)

return mu + eps*std

def forward(self, x):

# 인코딩

h = self.encoder(x)

mu, logvar = h.chunk(2, dim=-1)

# 재매개변수화

z = self.reparameterize(mu, logvar)

# 디코딩

x_recon = self.decoder(z)

return x_recon, mu, logvar학습 과정

VAE는 재구성 손실(reconstruction loss)과 KL 발산(KL divergence)의 합인 ELBO(Evidence Lower BOund)를 최대화하는 방향으로 학습됩니다. 이는 실제로는 음의 ELBO를 최소화하는 최적화 문제로 구현됩니다.

VAE의 미래와 한계

기대되는 발전 방향

- 더욱 정교한 잠재 공간 구조 학습

- 고차원 데이터에 대한 더 나은 생성 품질

- 다양한 도메인에 대한 일반화 능력 향상

- 확산 모델 등 다른 생성 모델과의 융합

현재 한계점

- GAN에 비해 상대적으로 흐릿한 이미지 생성

- 고차원 데이터에서의 표현력 한계

- 잠재 공간의 완전한 해석 가능성 부족

'IT&과학 > 인공지능' 카테고리의 다른 글

| 신경망의 숨은 보석, 심층 신뢰 신경망(DBN)의 세계로 빠져보자! (0) | 2025.04.21 |

|---|---|

| "AI의 창의적 대결: GAN이 예술가를 능가할 수 있을까?" (0) | 2025.04.21 |

| 자기부호화기(Autoencoder): 데이터 압축과 복원의 신경망 마법 (0) | 2025.04.20 |

| 게이트 순환 유닛(GRU): LSTM을 단순화한 신경망 구조 (0) | 2025.04.20 |

| 장단기 메모리(LSTM): RNN의 혁신적 발전과 응용 분야 (0) | 2025.04.20 |