1. Analytics 진화과정에 대하여 알아보기

Analytics 1.0 : Siloed 분석, Enterprise data warehouse(EDW) 기반, Online Analytics processing(OLAP) , Metadata 기반 분석

Analytics 2.0 : Genetic/evolutionary algorithms, 머신러닝, Predictive modeling 기반 분석

Analytics 3.0 : 빅데이터와 little-data의 기존 분석을 통합하여 뛰어난 예측 및 분석 통찰력을 제공

1.0은 전통적인 데이터 처리기술인 DW, 온라인 분석, 메터데이터 기술 등을 통해 기업내의 단일 도메인에 대한 데이터셋을 처리하는 목적으로 발전되었습니다.

2.0은 구글에서 MapReduce논문을 발표하고 Hadoop 과 같은 빅데이터 처리기술이 발전하면서 3V 즉, Velocity volume variety 등의 개념으로 정의된 빅데이터의 처리기술에 중점을 둔 개념이다.

3.0은 그동안의 데이터 관련 기술을 융합하여 분석에 따른 빠른 통찰력을 통해 비즈니스에 적용하는 개념을 말합니다.

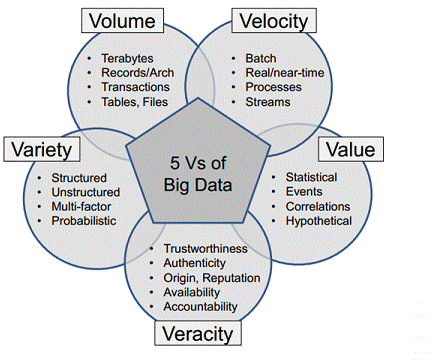

2. 빅데이터 5V에 대하여 알아보기

양(Volume) : 빅데이터는 당연히 대용량이다. 일례로 페이스북이 하둡(Hadoop) 데이터베이스에 저장하는 사진 문서 용량이 30,000TB에 이른다.

속도(Velocity) : 어마어마한 데이터가 아주 짧은 시간에 아주 빠르게 생성되고 사라지며, 아주 짧은 시간 동안만 유의미하다.

종류(Variety) : 흔히 비정형 데이터(Unstructured Data)로 불리는 것들, 즉 계량화 및 수치화가 힘든 데이터까지도 포함하는 것이 빅 데이터이다.

정확성(Veracity) : 빅데이터의 특성상 방대한 데이터들을 기반으로 분석을 하게 되는데, 이러한 분석에서 질이 높은 데이터를 활용하는 것이 분석의 정확도에 영향을 준다.

가치(Value) : 빅 데이터 분석을 통해 도출된 결론은 기업이나 조직의 당면한 문제를 해결할 수 있어야 하며 통찰력 있는 유용한 정보를 제공해야 한다.

3. Data governance(통합관리)에 대하여 알아보기

Analytics 1.0 시대에는 Data quality는 보장되지 않았고, 기본 레포트나 엑셀 정도의 데이터만 관리가 가능했다.

Analytics 2.0 시대 부터 시스템간의 데이터 인터페이스 연동 증가하여, 시스템간 모델 및 DB 형상 관리의 어려움 이 발생되었다. 조직의 목표에 부합해 최적의 정보 서비스 품질을 보장 하기 위하여 데이터를 연계 통합해 합리적인 의사결정을 도와주는 데이터 거버넌스가 필요하였음.

데이터 거버넌스는 데이터 자산 관리에 대한 권한, 통제 및 공유 된 의사 결정을 수행하는 것입니다.

데이터 거버넌스 성숙도 모델에는 5 단계가 있습니다.

초기 : 프로세스를 예측할 수없고, 제어력이 약하고 반응이 없습니다.

관리 대상 : 프로젝트를 위한 프로세스로 관리가 가능합니다.

정의 : 조직을 위해 특징 지어지는 프로세스로 사전 예방 적입니다.

양적으로 관리 : 프로세스는 정량적으로 측정되고 제어됩니다.

최적화 : 지속적인 프로세스 개선에 중점을 둡니다.

4. 데이터 관리자의 임무에 대하여 알아보기

기관 데이터 소스에 대한 이해를 높이고 내부에 포함 된 정보에 대한 액세스 및 지식을 위한 효율적인 프로세스를 구축하는 것 Stewardship , 품질 및 MDM 영역에 걸쳐 있음 이러한 기능을 포괄적 인 시각으로 통합하면 프로젝트 계획과 조직 구조 간의 갭을 해소 할 수 있음

5. Data warehouse와 Hadoop의 대하여 알아보기

- 데이터 창고(Data Warehouse)라는 이름에서 알 수 있듯 데이터를 저장해두는 것이 목적이다.

- DW에 데이터를 담기 위해선 데이터를 추출-변형-적재(ETL)이라는 과정을 거쳐야 함

- 빅데이터의 열쇠로 대변되는 하둡은 빅데이터 인프라 기술 중에 하나로 분산처리를 통해 수많은

데이터를 저장하고 처리하는 기술 (분산처리 시스템이 원리)

6. NLP는 Natural Language Processing

자연어 처리 기술’로 표현되며 단단히 짜여진 하나의 시스템보다는 텍스트 정보의 여러 측면을 분석하기 위한 다양한 소프트웨어 도구의 집합체라고 볼 수 있는 기술

(NLP (Natural Language Processing))는 텍스트 정보의 여러 측면을 분석하기위한 다양한 소프트웨어 도구 모음입니다. 일반적으로 텍스트를 수집하고 내용을 중심으로 메타 데이터를 추출하고 재구성하는 (Annotator) 명령으로 구성됩니다.

잘못된 부분의 지적은 언제든지 환영합니다.